Sztuczna inteligencja i Chat GPT sprawiły, że dotychczas poukładany świat contentu, gdzie wymagany był dokładny research i autorytet autorów, się zmienił. Nastąpił swego rodzaju Dziki Zachód zalewany masowo przez wygenerowane treści. Czy to oznacza, że autorzy i copywriterzy upadną lub pójdą na skróty? Czy firmy będą upraszczać sobie pracę, generując masowo artykuły? W wielu przypadkach oczywiście tak już się dzieje. Jak zatem sprawdzić, czy dany tekst został stworzony przez robota? Strażnikiem contentu są pojawiające się coraz to nowsze detektory AI, które zdaniem twórców są w stanie skutecznie zweryfikować dany tekst. Postanowiliśmy to sprawdzić!

Spis treści:

Myślisz sztuczna inteligencja, mówisz ChatGPT. To właśnie ten model językowy, wykorzystujący uczenie maszynowe do generowania tekstu można uznać za najpopularniejszy. Aktualizacja wersji Open AI – czyli wersja Chat GPT 4 – ruszyła w marcu 2023 roku. W porównaniu do poprzedniej (3.5), jest w stanie udzielić poprawnych odpowiedzi na bardziej złożone pytania w nawet 26 językach. W interakcji można liczyć na szybszą, sprawniejszą i dokładniejszą odpowiedź. Od twórców dowiadujemy się następujących informacji:

„Spędziliśmy 6 miesięcy, czyniąc GPT-4 bezpieczniejszym i bardziej wyrównanym. Z naszych wewnętrznych ocen wynika, że GPT-4 jest o 82% mniej skłonny do odpowiadania na żądania dotyczące niedozwolonych treści i o 40% bardziej skłonny do udzielania odpowiedzi opartych na faktach niż GPT-3.5.”

(źródło: https://openai.com/gpt-4)

Co to oznacza przy tworzeniu contentu? Wszystkie narzędzia wykorzystujące sztuczną inteligencję są w stanie usprawnić, a w wielu przypadku „turbodoładować” proces tworzenia. Automatyzacja wielu procesów i oszczędność czasu często służą do ekspresowego tworzenia m.in. artykułów blogowych, opisów produktów, kategorii, sekcji FAQ lub postów na social media.

Autorzy, copywriterzy i agencje są teraz w stanie generować dla swoich, wielokrotnie niczego nieświadomych klientów dziesiątki, setki lub tysiące artykułów, które na pierwszy rzut oka wydają się merytoryczne, są dobrze skomponowane i napisane zgodnie z wytycznymi dotyczącymi zasad SEO i słów kluczowych. Często jednak problem pojawia się w momencie dokładniejszego analizowania tekstu.

W Altavia Kamikaze + K2 mamy nieco inne podejście i stawiamy na jakość, a wszystkie treści tworzymy na podstawie wiedzy i doświadczeniu autorów. Wszystko po to, by dostarczać content premium, zawierający wartość dodaną, która jest w stanie pomóc w realizacji wcześniej założonych celów. O tym, jak to robimy, dowiesz się więcej: Jakościowy content, czyli jaki? Jak robimy to w K2 Precise.

Sztuczna inteligencja nie jest nieomylna, a w wielu przypadkach „wypluwa” nieprawdziwe informacje lub przykłady, które nie mają nic wspólnego z rzeczywistością. Wrzucanie na swoją stronę tekstu bez wcześniejszej weryfikacji może negatywnie odbić się na wizerunku danej firmy/witryny. Jeśli więc prowadzisz bloga i uważasz się za eksperta – zdecydowanie nie warto praktykować strategii typu „kopiuj-wklej” z chatu GPT.

Świadomość właścicieli stron, w tym również e-commerce’ów, na temat masowo generowanych publikacji wciąż rośnie. Wiele osób zadaje pytania „jak do treści generowanych przez AI podchodzi Google?”. Tutaj najodpowiedniejsza jest odpowiedź: „to zależy”. O ile w krótkiej perspektywie strony wykorzystujące treść masowo generowaną przez sztuczną inteligencję poszybowały w górę w wynikach wyszukiwania, to równocześnie wielu specjalistów przeprowadziło testy, z których wynika, że taka taktyka w dłuższej perspektywie może witrynie zaszkodzić. Co na to Google?

„W przypadku treści generowanych automatycznie nasze wytyczne nie zmieniły się od lat. Korzystanie z rozwiązań automatyzacji – również z AI – do generowania treści, których głównym celem jest manipulowanie rankingiem w wynikach wyszukiwania, stanowi naruszenie naszych zasad dotyczących spamu.

Google ma wiele lat doświadczenia w dziedzinie automatyzacji używanej do oszukiwania w wynikach wyszukiwania. Nasze wysiłki na rzecz walki ze spamem – w tym nasz system SpamBrain – będą kontynuowane niezależnie od metody generowania spamu.

Trzeba jednak pamiętać, że nie przy każdym użyciu rozwiązania automatyzacji, w tym AI, generują spam. Automatyzacja od dawna jest wykorzystywana do generowania przydatnych treści, takich jak wyniki sportowe, prognozy pogody czy transkrypcje. AI może otworzyć nowe poziomy ekspresji i kreatywności oraz być kluczowym narzędziem wspierającym tworzenie świetnych treści internetowych.

Takie podejście jest zgodne z naszą dotychczasową koncepcją zapewniania użytkownikom większych możliwości dzięki nowym technologiom. Nadal będziemy odpowiedzialnie podążać tą ścieżką, zachowując jednocześnie wysokie standardy jakości informacji i ogólnej przydatności treści w wyszukiwarce”.

(źródło: https://developers.google.com/search/blog/2023/02/google-search-and-ai-content?hl=pl)

Co to oznacza? Wszystko i nic. Natomiast jedno jest pewne – Google nie zezwala na tworzenie treści, które mają za zadanie manipulować rankingiem w wynikach wyszukiwania – bez względu na to, w jaki sposób powstały. Oznacza to zatem, że w rozumieniu przedsiębiorstwa, treści tworzone przez AI mogą być przydatne! Google od lat wspiera najnowsze technologie i korzystanie z nich, więc ciężko, aby opowiedział się przeciwko nim. Będzie jednak nadal toczyć walkę ze słabej jakości treściami – niezależnie od tego, spod czyjego pióra wyszły.

Detektory AI to narzędzia, które są modelami językowymi, opierającymi się na sztucznej inteligencji. Ich zadaniem jest analiza, identyfikacja, klasyfikacja i rozpoznawanie określonych danych zawartych w tekście. Z założenia pomagają wykryć treści stworzone przez sztuczną inteligencję (np. przez Chat GPT) i odróżnić je od tych napisanych przez człowieka.

Tego typu narzędzia podczas analizy contentu weryfikują i analizują pojedyncze słowa w kontekście danego ich zbioru. Program rozpoznaje konkretny zwrot i za pomocą algorytmów oblicza, jakie sformułowania mogą pojawić się jako następne. Na czym dokładnie bazują detektory AI? Chodzi tu głównie o przewidywanie – można śmiało powiedzieć, że teksty generowane przez SI są bardzo podobne pod względem schematu i słownictwa. Do tego dochodzi brak kreatywności. W takich artykułach nie znajdziemy głębokich anegdot i porównań. Teksty generowane nie są nacechowane emocjonalnie i w zależności od użytego promptu różnią się od siebie m.in. długością.

W sieci znaleźć można wiele programów wykrywających fragmenty generowane przez sztuczną inteligencję. W swoim teście wykorzystamy takie narzędzia jak:

Do każdego z tych narzędzi wrzuciliśmy opis dla kategorii z matami wiklinowymi napisany wcześniej przez content specjalistę. Co się okazało?

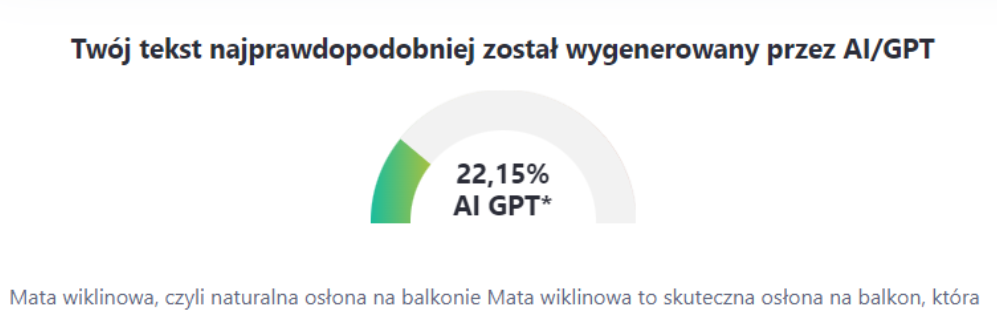

ZeroGPT – według wyniku programu tekst został w 22% wygenerowany przez sztuczną inteligencję:

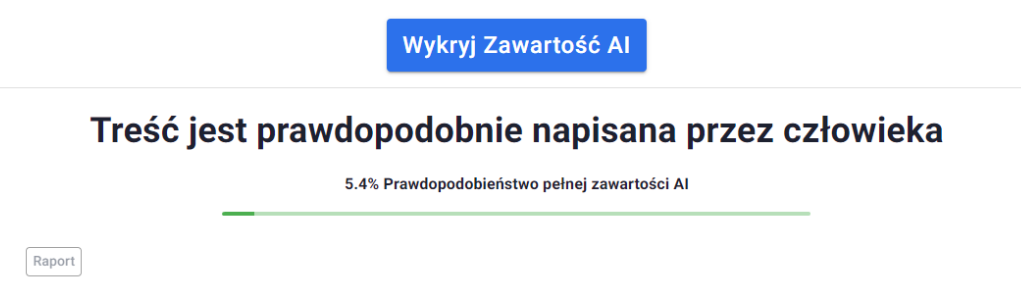

Smodin – według tego programu tylko 5.4% treści prawdopodobnie jest napisana przez SI:

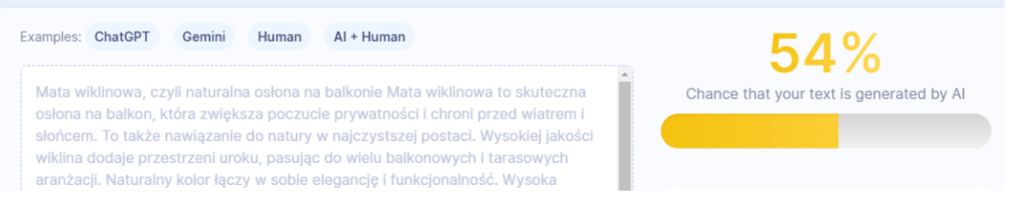

Scribbr – tutaj mamy rekord. Narzędzie pokazuje 54% szansy, że tekst został wygenerowany przez AI:

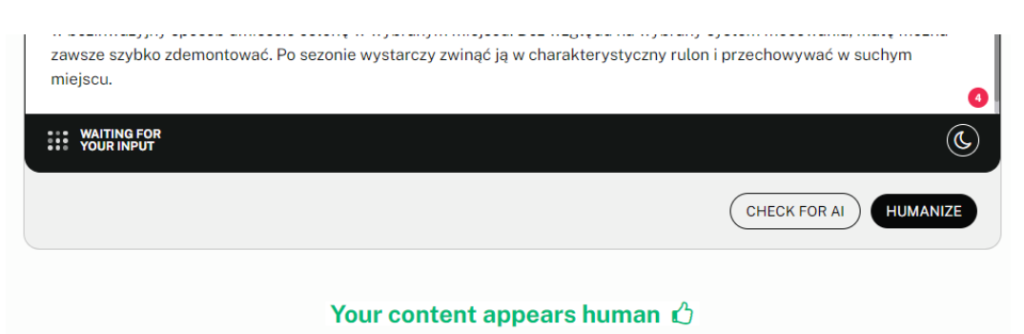

Undetectedable AI – tutaj tekst jest napisany przez człowieka:

GPTZero – istnieje prawdopodobieństwo, że 5% tekstu zostało napisane przez AI:

Content at Scale – Passes as Human!

Writer – narzędzie pokazuje optymistyczne 97%:

Co ciekawe wynik z danego detektora otrzymany w jednym momencie może różnić się znacząco od wyniku podczas testu wykonanego nab tym samym artykule za jakiś czas.

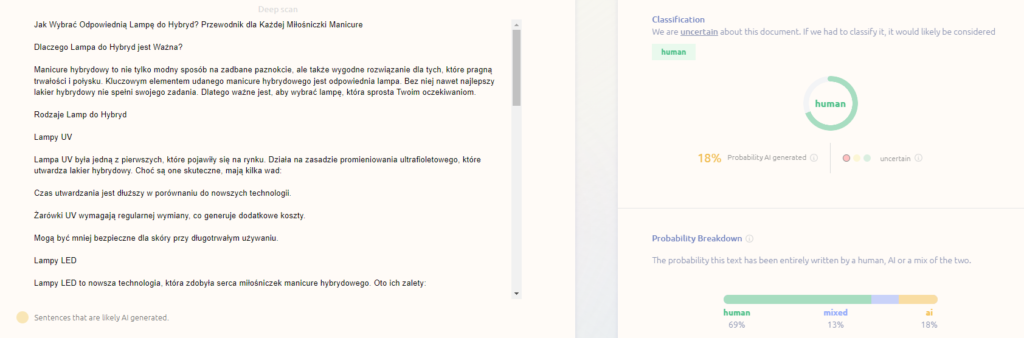

Przykładem może być następująca sytuacja – gdy zaczynaliśmy testować detektory, jeden z nich, a konkretnie GPTZero natychmiastowo klasyfikował tekst przeklejony z Chatu GPT i nie poddany żadnej redakcji jako napisany w 100% przez AI. Teraz natomiast – niekoniecznie. Wystarczy szybki prompt – prośba o wygenerowanie artykułu na temat tego, jak dobrać lampę do hybryd – kopiuj-wklej otrzymanego tekstu do narzędzia wykrywającego, aby przekonać się, że detektor jest w błędzie.

Wynik z detektora ZeroGPT:

Co ciekawe w tym samym momencie, inne detektory też nie poradziły sobie z wykrywaniem treści napisanej przez AI.

Wynik z detektora Content at Scale:

Wynik z detektora GPTZero:

Wnioski – detektory AI nie są nieomylne, a ich wyniki mogą znacznie się od siebie różnić. Ich zdolność do oceny, czy teksty zostały napisane przez człowieka lub AI, nie jest perfekcyjna, a często wręcz ułomna. Obecnie nie radzą sobie zarówno z odpowiednim klasyfikowaniem treści napisanej w 100% przez człowieka, jak i z wykrywaniem treści w pełni stworzonej przez AI.

Podsumowując, detektory AI mają pewne ograniczenia, a samo wykrywanie treści AI polega głównie na przewidywaniu i prawdopodobieństwie. To znacząco opóźnia proces poprawnego rozróżnienia tekstu napisanego przez człowieka lub wytworzonego przez narzędzie za pomocą określonych promptów. Można z nich korzystać, ale zdecydowanie lepiej jest po prostu – tworzyć wysokiej jakości artykuły, posiłkując się wiedzą i doświadczeniem autora, a w razie potrzeby wspomagać się najnowszymi technologiami. W takim wypadku jakikolwiek wynik z detektora AI nie będzie miał większego znaczenia. Takie podejście zdaje się też zgodne z oficjalnym stanowiskiem Google.

Generatory tworzenia treści AI wykorzystują już dostępne informacje z internetu, które wcześniej zostały napisane przez człowieka. Czy tekst AI jest utworem podlegającym pod prawa autorskie? Nie. Sztuczna inteligencja nie jest człowiekiem, więc to, co wygeneruje nam program, nie jest chronione prawem autorskim. Oznacza to, że taki tekst nie będzie należał twórcy (np. copywritera).

Dobrym przykładem jest sprawa Stephana Thalera. Mężczyzna, który jest specjalistą z zakresu sztucznej inteligencji, postanowił zarejestrować swój wygenerowany przez SI utwór w Copyright Office. Urząd kilkukrotnie odmówił, a Thaler skierował sprawę do sądu. Argumentował to tym, że AI jest autorem, ale to on jest odpowiedzialny za dany model sztucznej inteligencji. W tak stworzonym utworze automatycznie doszło do przeniesienia praw autorskich ze względu na tworzenie tzw. utworu na zamówienie. Sąd jednak nie uznał racji Thalera, a argumentował to tak:

„Prawo autorskie ewoluuje, ale istotą jego istnienia jest zawsze ochrona twórców-ludzi. W związku z tym to, co wygeneruje algorytm, nie jest chronione”.

W przypadku jedynie samego wspierania się narzędziem problem nie istnieje. Gdy jednak w 100% opieramy swój content na korzystaniu z AI, możemy napotkać sporo problemów – być może nie wykażą ich detektory – natomiast prawa autorskie do tekstu, jego merytoryczność i jakość stoją w takim przypadku pod znakiem zapytania.